96GB内存+1280亿参数支持!AMD锐龙AI MAX+令人震撼

近日,AMD凭借其锐龙AI MAX+处理器,在消费级PC的AI应用方面取得了重大突破,为这一领域带来了新的活力。

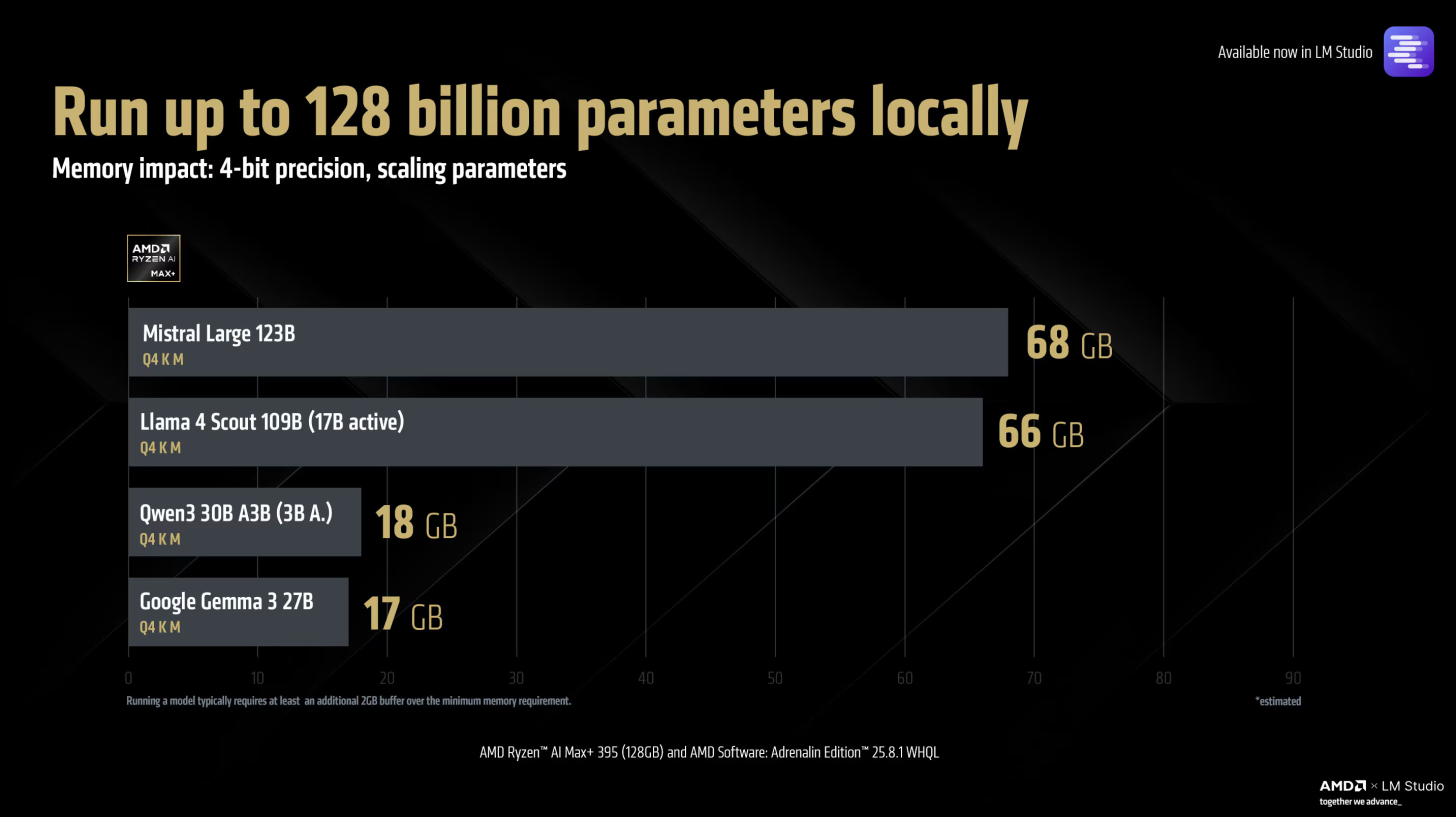

AMD一直是推动AI计算普及的重要力量,其通过XDNA引擎,成功将大规模AI计算引入消费级设备。旗下的Strix Point和Strix Halo系列APU产品,凭借出色的AI性能,在市场上占据了一席之地。而此次,随着Adrenalin Edition 25.8.1驱动程序的发布,AMD再次将边缘AI提升到了新的高度。该驱动程序支持高达1280亿参数的大型大语言模型(LLM),这意味着消费级PC用户现在可以在本地运行像Meta的Llama 4 Scout这样先进的模型,这在以往是难以想象的。

AMD可变图形内存(VGM)技术是此次突破的关键之一。通过这项技术,消费者能够为集成显卡分配高达96GB的图形内存,为大型模型在PC上的本地运行提供了充足的内存支持。以Llama模型为例,虽然它是基于专家混合(MoE)的实现,运行时仅利用170亿参数,但在充足的内存支持下,用户可以获得不错的每秒标记数(TPS),从而将该模型作为功能强大的AI助手使用,无论是文本生成、智能问答还是其他任务,都能轻松应对。

除了内存支持,AMD在模型上下文大小方面也取得了显著进展。在消费级处理器领域,通常的上下文长度标准约为4096个标记。而AMD通过技术创新,将这一数值大幅提升至256,000个标记。这意味着用户在进行各种任务时,能够拥有更长的上下文信息,从而更好地掌控工作流程,无需担心因上下文不足而导致的性能问题。这一突破进一步拓展了消费级PC在AI应用方面的可能性。

然而,目前Strix Halo平台的应用还面临一些限制。该平台仅在有限数量的设备上可用,且这些设备大多价格昂贵,部分产品价格甚至超过2000美元。这使得普通消费者在购买时面临一定的经济压力。不过,AMD在AI计算方面的进步无疑是值得肯定的,它为消费级PC的AI发展指明了方向,也让更多人看到了AI算力普及的希望。随着技术的不断发展和成本的逐渐降低,相信未来会有更多消费者能够享受到AMD带来的强大AI算力。