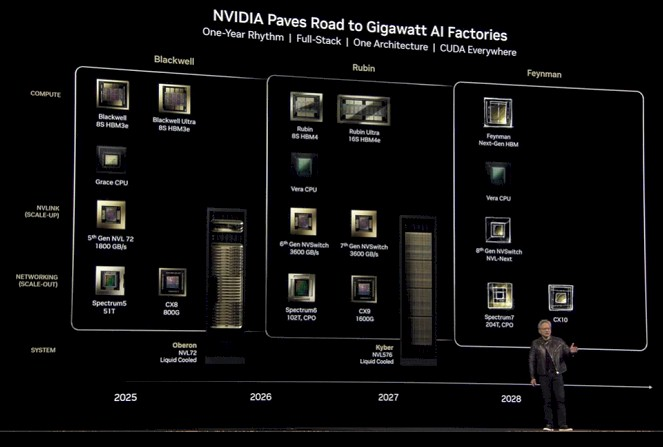

英伟达2028路线图曝光:从Blackwell到Feynman,下一个十年的AI芯片霸权”

NVIDIA近日公布了其至2028年的GPU系统路线图,展示了公司在人工智能计算领域的雄心壮志。这一路线图不仅涵盖了GPU、CPU、网络互连技术,还涉及数据中心和AI推理平台的未来发展方向。NVIDIA通过这一计划,旨在巩固其在AI训练和推理市场的主导地位,同时应对来自超大规模企业和云服务提供商的竞争压力。

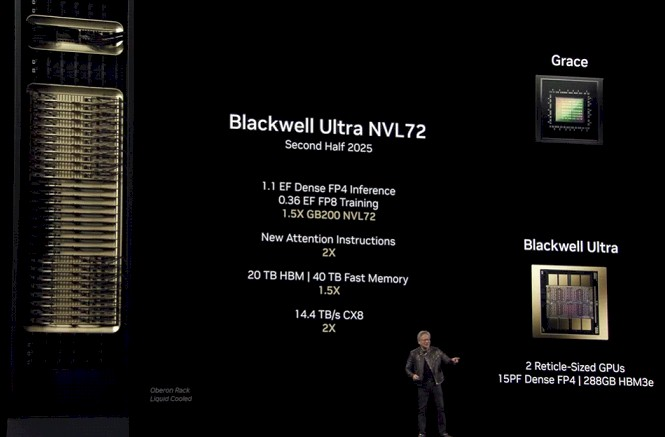

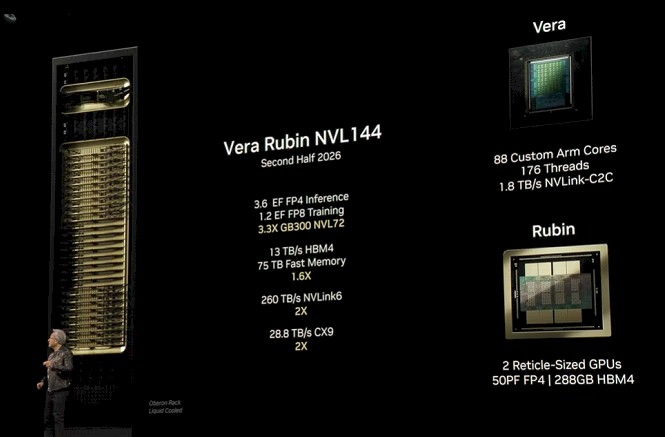

路线图的核心是NVIDIA的GPU加速器系列,从当前的“Blackwell”B100和B200,到未来的“Rubin”和“Feynman”架构,性能将呈指数级增长。例如,2025年推出的“Blackwell Ultra”B300 GPU将内存容量提升50%,达到288GB,并支持更高的计算密度。而2026年的“Rubin”R100 GPU将进一步升级至HBM4内存,带宽提升62.5%,达到13TB/秒。

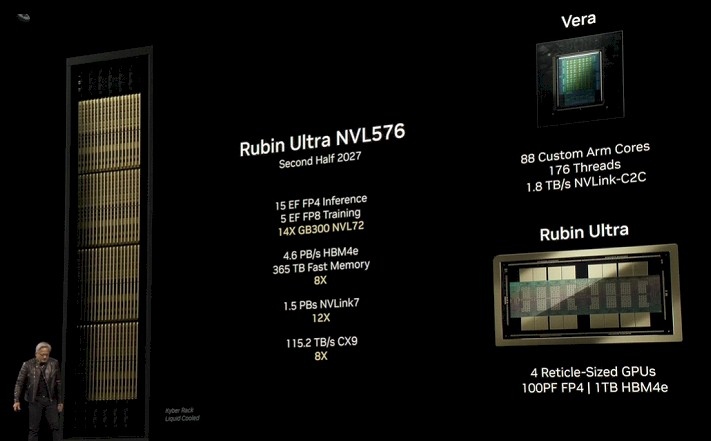

NVIDIA还计划通过创新的机架设计(如代号“Kyber”的液冷系统)和网络技术(如NVLink 7和NVSwitch 6)来优化大规模AI工作负载的性能。到2027年,NVIDIA的“Rubin Ultra”系统将实现21倍于当前GB200系统的性能,提供15 exaflops的FP4推理能力和5 exaflops的FP8训练能力。

此外,NVIDIA的路线图还强调了CPU与GPU的协同发展。2026年推出的“Vera”CV100 Arm处理器将支持同步多线程技术,提供176个线程,并与GPU通过高速NVLink C2C链路连接,带宽达到1.8TB/秒。

NVIDIA的这一路线图不仅是为了满足市场对AI计算需求的爆炸性增长,更是为了应对未来可能出现的技术挑战。通过公开这一计划,NVIDIA向客户和竞争对手展示了其在AI计算领域的长期承诺和技术领先地位。随着AI模型的复杂性和规模不断扩大,NVIDIA的路线图无疑将成为全球科技行业的重要参考。